Testando seu Modelo

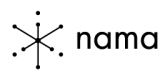

Playground, um espaço interativo, um ambiente projetado especificamente para a experimentação com as ferramentas da plataforma Nama

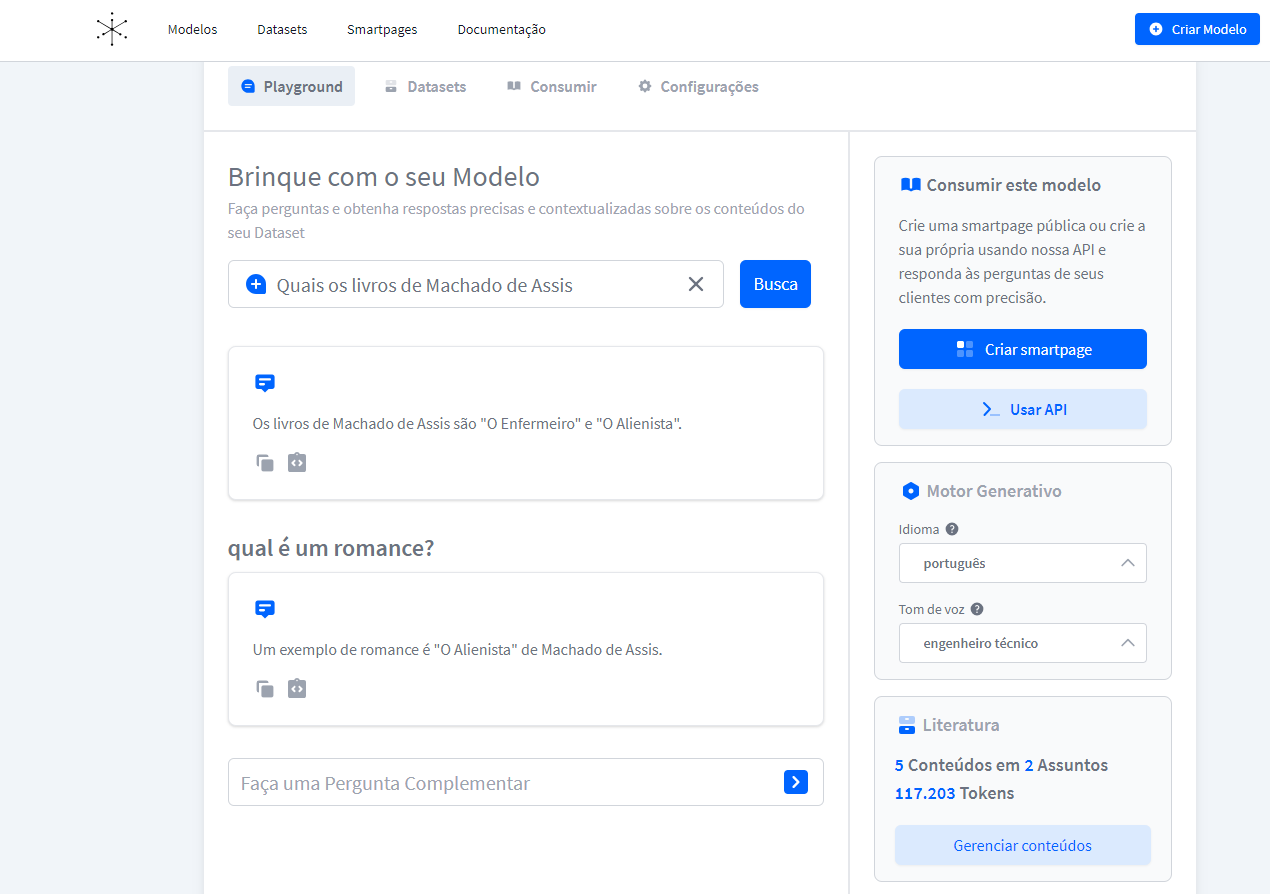

Com seu Modelo pronto, explore o Playground e teste as respostas com base nas perguntas relacionadas ao Dataset selecionado.

Acesse o Playground de cada modelo na aba Modelos e selecione o Modelo desejado.

Formule perguntas pertinentes ao Dataset e avalie a adequação das respostas para seus objetivos.

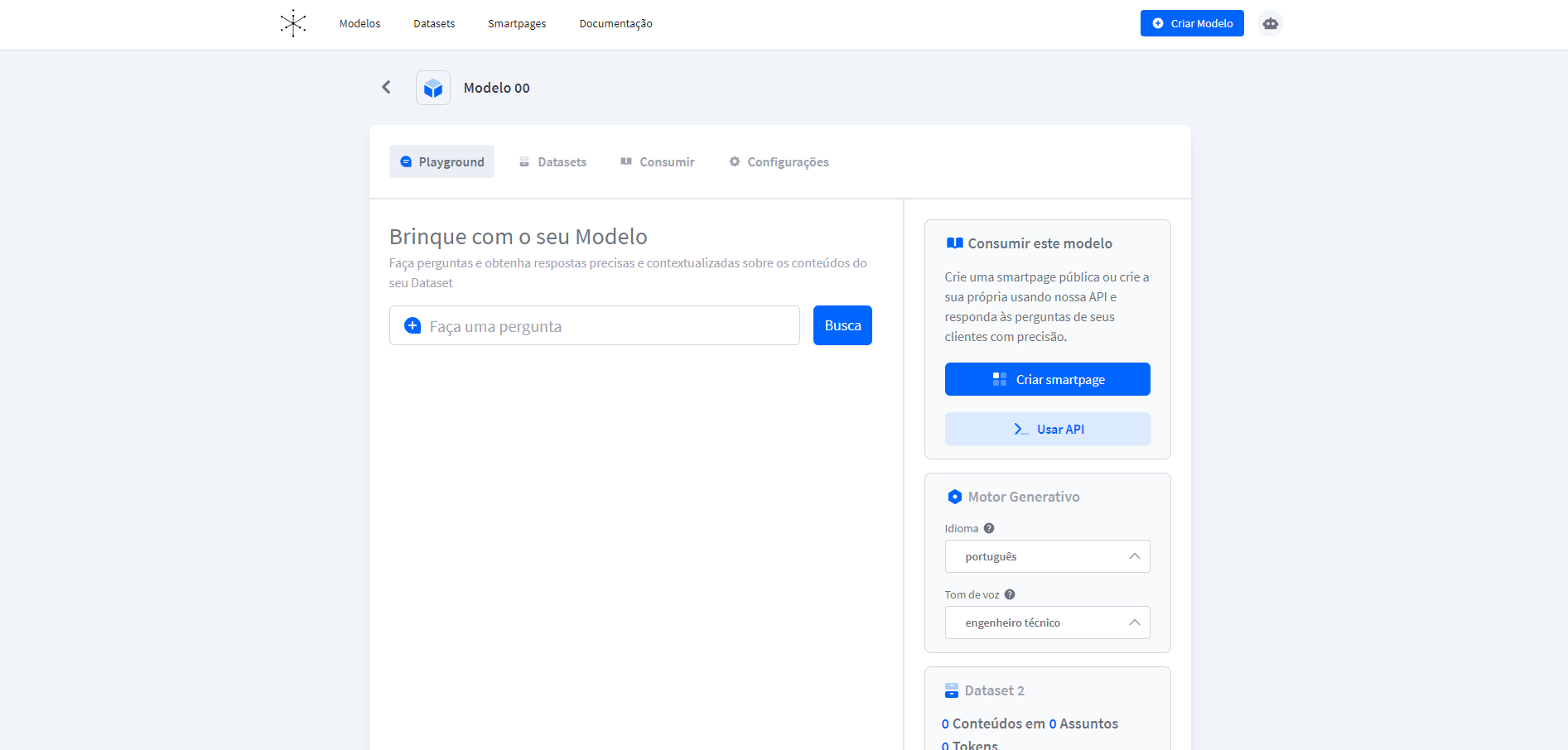

Na aba Dataset você poderá verificar o Dataset em uso, os demais Datasets existentes e criar um novo, se necessário.

DicaLembre-se de verificar se o Dataset em uso é o que deseja testar.

Experimente perguntas que exijam respostas mais detalhadas e precisas.

Se necessário, teste em diferentes idiomas e tons de voz para personalizar a experiência do usuário.

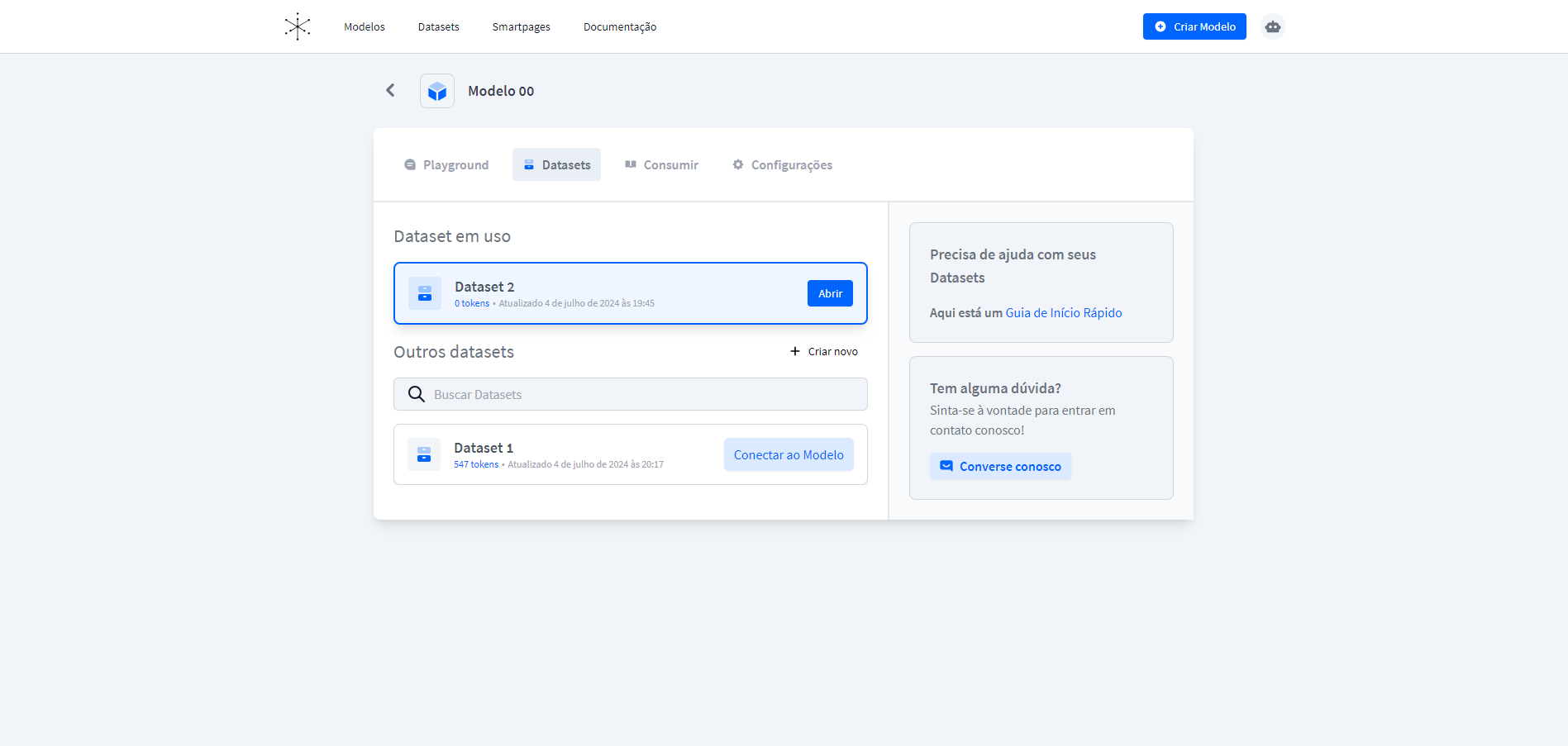

Quando estiver satisfeito com o desempenho do modelo, vá para a aba Consumir e obtenha sua chave de API para integrar o modelo à plataforma onde deseja que seus colaboradores interajam com ele.

Compartilhe a documentação técnica com sua equipe para integrar o modelo aos seus aplicativos ou serviços.

Configurando o Motor Generativo

Na aba Playground você pode ajustar a língua e o tom de voz do seu modelo.

Por exemplo, você pode escolher entre inglês, espanhol, ou outras línguas suportadas. Além disso, você pode selecionar um tom de voz específico para o seu modelo, como técnico, preciso, ou até mesmo comediante de stand-up.

DicaLembre-se de escolher um tom de voz adequado ao seu público e caso de uso.

Gerando um Histórico

O Nama AI Search permite o uso do Histórico para manter o contexto da conversa!

Este recurso é essencial para criar interações mais coerentes e naturais, especialmente em diálogos complexos ou prolongados.

Ao realizar uma pergunta complementar, a IA utiliza o contexto da busca anterior para gerar uma resposta completa. Isso enriquece a resposta e mantém a coerência do diálogo! ✨

Consumo de Tokens

Ao utilizar o histórico cada interação adicionada ao histórico aumenta a quantidade de textos na requisição. Além disso, a resposta da API pode ser mais detalhada para manter a coerência com o histórico.

Como consequência, ocorre um aumento do consumo de tokens.

Gerenciar o Consumo de Tokens

Uma das formas de melhor gerenciar o consumo de tokens é limitar o tamanho do histórico, incluindo apenas as interações mais recentes e relevantes. Interações antigas ou menos importantes devem ser removidas.

A API para trazer o histórico é uma poderosa ferramenta para manter o contexto da conversa e deve ser usada com cuidado para evitar o aumento excessivo do consumo de tokens.

Implementar práticas de limitação do histórico podem ajudar a manter os custos sob controle enquanto oferece interações coerentes e relevantes. 😉

Updated 3 months ago